گیج شدن هوش مصنوعی از به تصویر کشیدن همسر آسیایی مارک زاکربرگ

متا اخیراً تولیدکننده تصاویر مبتنی بر هوش مصنوعی خود را راهاندازی کرده است که از دادههای آموزش دیده توسط انسان برای تولید تصاویر متناسب با توضیحات متنی استفاده میکند. اما تحقیقات نشان میدهد این سیستم تا حد زیادی نمیتواند مواردی مانند ترکیب نژادهای مختلف را در تصاویر تولید کند. پس از آنکه کاربران متوجه شدند این سیستم قادر به خلق تصویری از یک مرد آسیایی با همسر سفیدپوست نیست تولیدکننده تصاویر هوش مصنوعی متا متهم به تعصب نژادی شده است.

تولیدکننده تصاویر به نام «ایمجین» که به هوش مصنوعی مجهز شده است در پایان سال گذشته میلادی راهاندازی شده است. این سیستم قادر است بر اساس توصیف متنی تقریباً هر موضوعی را در قالب تصویر واقعی تولید کند.

اما کاربران متوجه شدند این هوش مصنوعی قادر به خلق تصاویری از زوجهای با نژاد های متفاوت نیست. هنگامی که از این ابزار درخواست می شود تا تصویری از یک مرد آسیایی با همسر سفیدپوست ارائه دهد، تنها تصاویری از زوجهای آسیایی نشان داده شد.

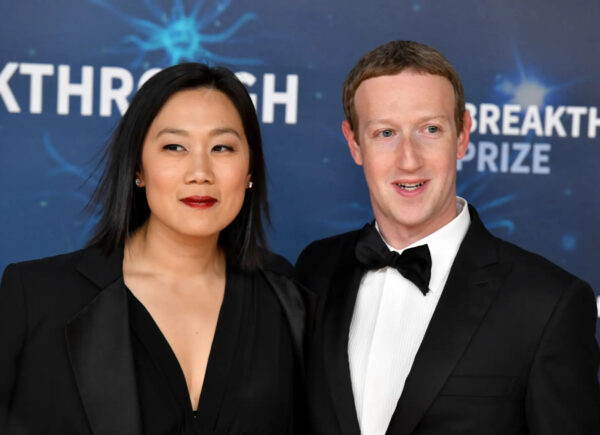

ماجرا بدین ترتیب است که پریسیلا چن، دختر مهاجران چینی به آمریکا، در حین تحصیل در دانشگاه هاروارد با مارک زاکربرگ آشنا شد. این زوج در سال 2012 ازدواج کردند.

برخی کاربران تصاویری از زاکربرگ و چن را در شبکه اجتماعی ایکس به اشتراک گذاشتند و با لحن طنز و شوخی نوشتند که موفق شدهاند با استفاده از ابزار ایمجین چنین تصاویری را خلق کنند.

این موضوع نشاندهنده محدودیتهای ذاتی سیستمهای هوش مصنوعی در خلق تصاویری با نژاد های مختلف است و نقصهایی در آموزش های دیده شده توسط این سیستمها در مورد تنوع نژادی را برجسته میکند.

متا در ابتدا به درخواست مصاحبه با رسانهی ما، که خارج از ساعات کاری معمول انجام شده بود، پاسخ نداد. متا به هیچ وجه اولین شرکت بزرگ فناوری نیست که به خاطر داشتن هوش مصنوعی”نژادپرستانه” مورد انتقاد قرار گرفته است. در فوریه گذشته، گوگل مجبور شد تولید تصاویری با استفاده از سیستم جیمینی خود را متوقف کند، چرا که کاربران متوجه شدند این سیستم تصاویری تاریخی غیردقیق تولید میکند. کاربران مشاهده کردند سیستم مذکور تصاویری از نازیهای آسیایی در آلمان سال 1940، وایکینگهای سیاهپوست یا زنان شوالیه قرون وسطایی تولید میکند.

در آن زمان، گوگل گفت: تولیدکننده تصاویر جیمینی محدوده وسیعی از مردم را پوشش می دهد که بطورکلی چیز خوبی است، چرا که مردم در سرتاسر جهان از آن استفاده میکنند. اما در این مورد اشتباه عمل کرده است.

اما تعصبات نژادی مصنوعیهای هوشمند مدتهاست مورد توجه است. دکتر ناکیما اشتفلباوئر، متخصص اخلاق هوش مصنوعی و مدیرعامل شبکه زنان در فناوری فراونلوپ، به بیزنس اینسایدر گفته بود که وقتی الگوریتمهای پیشبینیکننده یا هوش مصنوعیهای به طور گسترده مورد استفاده قرار میگیرند، شناسایی اینکه این پیشبینیها اغلب بر اساس نظرات جمعی، تنگنظریها یا دروغها تکیه دارند دشوار میشود.

دکتر ناکیما اظهار داشت: پیشبینیهای الگوریتمی باعث تنگنظری و هدف قرار دادن غیرعادلانه افراد و جوامع، بر اساس دادههایی که از منابعی مانند ردیت به دست آمده، میشوند. سیستمهای تولیدکننده مانند جمینی و ایمجین بر روی مقادیر عظیمی از دادههای به دست آمده از جامعه آموزش دیدهاند. اگر تعداد تصاویر زوجهای دارای نژاد های مختلف در دادههای مورد استفاده برای آموزش مدل کم باشد، میتواند دلیل دشواری هوش مصنوعی در تولید این نوع تصاویر باشد.